En el verano de 2017, un grupo de investigadores de Google Brain publicó discretamente un artículo que cambiaría para siempre el rumbo de la inteligencia artificial. Titulado "Attention Is All You Need" (La Atención es Todo lo que Necesitas), este trabajo académico introdujo una nueva arquitectura neural llamada Transformer, que revolucionó la forma en que las máquinas procesan y comprenden el lenguaje.

Una Nueva Era en el Procesamiento del Lenguaje

Antes de los Transformers, el procesamiento del lenguaje natural dependía de redes neuronales recurrentes (RNN) que analizaban el texto palabra por palabra, un proceso lento y limitado. La innovación del equipo de Google Brain fue eliminar esta secuencialidad, permitiendo que el modelo pudiera examinar todas las palabras de una oración simultáneamente mediante un mecanismo llamado "atención".

Esta arquitectura permite que el modelo determine cómo cada palabra se relaciona con las demás, creando una comprensión más profunda y contextual del texto. El resultado fue sorprendente: un sistema más rápido, eficiente y notablemente mejor en el manejo de textos largos.

El Impacto en la IA Moderna

El impacto de los Transformers ha sido extraordinario. Esta arquitectura forma la base de modelos populares como:

- GPT de OpenAI

- BERT de Google

- LLaMA de Meta

- Claude de Anthropic

- Bard de Google

La velocidad de procesamiento y la capacidad de entrenamiento con grandes conjuntos de datos han permitido avances significativos en:

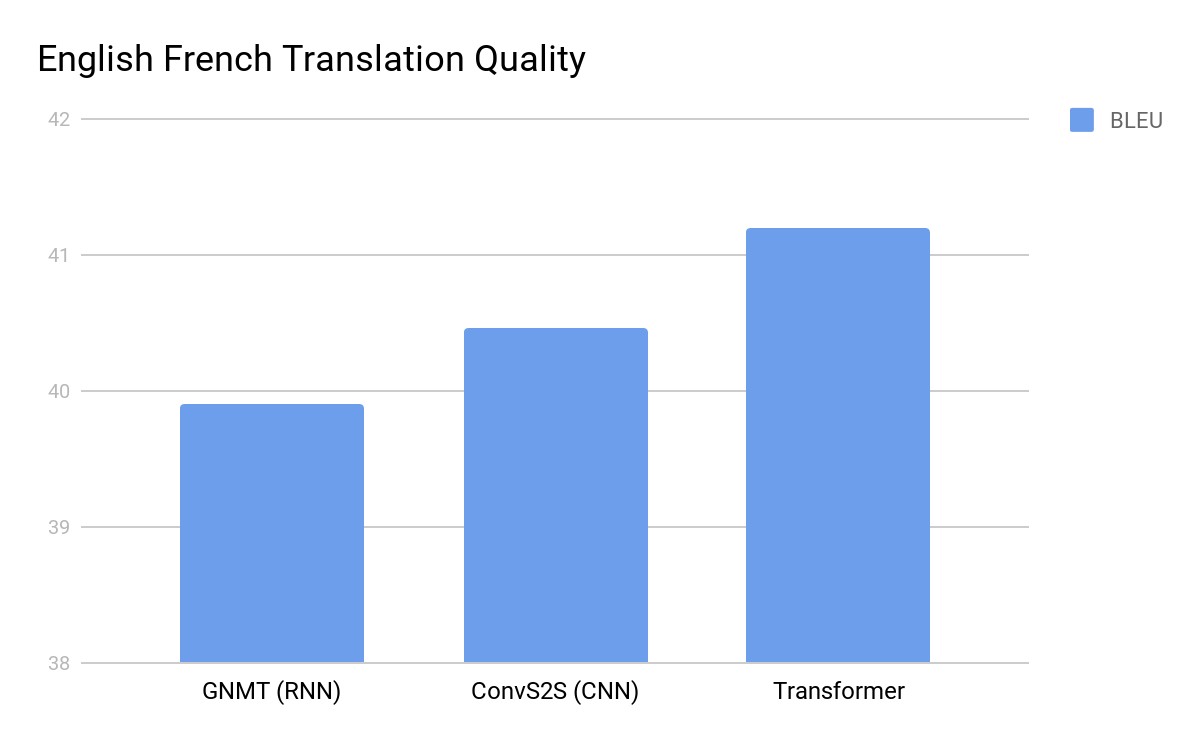

- Traducción automática

- Generación de texto

- Análisis de sentimientos

- Respuesta a preguntas

- Resumen de textos

Más Allá del Lenguaje

Los Transformers han demostrado ser versátiles más allá del procesamiento del lenguaje. Su arquitectura se ha adaptado exitosamente para:

- Generación de imágenes

- Análisis de música

- Programación automática

- Investigación biomédica

- Pronósticos financieros

Desafíos y Preocupaciones

El éxito de los Transformers también ha generado nuevos desafíos:

- Alto consumo de recursos computacionales

- Preocupaciones sobre desinformación

- Cuestiones de derechos de autor

- Sesgos en los datos de entrenamiento

- Necesidad de regulación

El Futuro

La comunidad científica continúa innovando con nuevas variantes como Performer, Longformer y Reformer, buscando mejorar la eficiencia y capacidades de los Transformers. El impacto de esta tecnología sigue expandiéndose, redefiniendo los límites de lo posible en la inteligencia artificial.